13 KiB

title, date, cover

| title | date | cover |

|---|---|---|

| Intelligence Artificielle et réalité | 2025-10-28 | images/cover.png |

Introduction

Depuis quelques mois, je vois fleurir des billets et des tutos pour « bloquer les bots d’IA » — souvent les mêmes noms, les mêmes règles robots.txt, les mêmes listes d’IP à bannir.

Dans le même temps, les deepfakes pullulent et les timelines s’emplissent d’images « choc » calibrées pour générer du clic.

Tout cela contribue au développement d'une inquiétude devenue le thème d’articles sérieux, parfois universitaires : l’IA façonnerait notre perception du réel. Le problème n'est pas nouveau, mais le volume, la vitesse et l’échelle changent la donne.

Alors qu'en 2023 j’étais frontalement hostile aux IA génératives et à leur modèle d’entraînement, j’ai changé mon fusil d'épaule : j’utilise l’outil en gardant mon esprit critique, occasionnellement à des fins exploratoires, et je défends depuis l’idée qu’empêcher l’IA d’apprendre est une faute intellectuelle.

Quelques rappels utiles

Une IA ne « veut » rien. Elle ne décide pas de falsifier une image ni d’inventer une citation ; elle répond à une demande. Elle peut halluciner (terme particulièrement représentatif du problème de mythe partagé que je développe ci-dessous puisqu'il ne s'agit pas d'hallucination dans le sens commun du terme), se tromper, déraper — et les fournisseurs sérieux l’admettent. Mais elle n’invente rien ex nihilo : elle façonne des sorties à partir de distributions apprises sur des données.

Par corollaire : si on nourrit un modèle avec de mauvaises données, il produira des mauvaises réponses. Et si on organise activement une disette de contenu de qualité, on affame la connaissance commune. C’est l’argument central de ma position : interdire l’accès de l’IA au savoir public est une trahison intellectuelle — et un aveu d’échec du web comme bien commun.

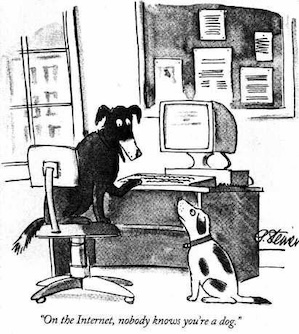

Enfin, n’oublions pas que nos sociétés vivent déjà sur des fictions partagées, comme le démontre habilement Yuval Noah Harari dans son œuvre (déjà dans la trilogie Sapiens, puis, plus explicitement, dans Nexus). L’argent, la Nation, l’Entreprise, la Popularité : ce sont des mythes performatifs, servant une narration théâtralisée de la Vie. L’IA ne crée pas ce régime — ce n'est qu'un perroquet stochastique, encore une métaphore... C'est nous, humains, qui l'encourageons à y participer, avec une efficacité redoutable.

Cet ancrage dans les mythes est si important qu'il se retrouve dans le langage, parlé et écrit, où les mots n'ont plus leur sens d'origine. Les métaphores et allégories, si poétiques lorsque utilisées avec parcimonie, si tranchantes lorsque utilisées dans les critiques, sont devenues indispensables dans le langage courant. Au point qu'on finit par reprocher à certaines catégories de personnes (à tout hasard, les autistes) d'être "trop littéraux", quand ce sont, en réalité, les autres qui sont "trop abstraits"... et incapables de se rappeler ce qui est "vrai", ce qui est "réel".

Blâmer l’outil, dédouaner l’utilisateur

Psychologiquement, c’est confortable. On refuse la responsabilité individuelle : « ce n’est pas moi, c’est l’algorithme ». Comme on accusait hier la littérature, puis le cinéma, puis les jeux vidéo, d’engendrer la violence. L'IA est un outil hautement technique que l'on a transformé en un jouet, en instrument de loisir et de fun. On désintellectualise l'IA avant de l'accuser de notre abrutissement, pour mieux refuser d'admettre que nous en sommes à l'origine.

Le rapport avec Dieu est toujours intéressant, et plus encore lorsqu'on l'analyse à la lumière de la technologie. Dieu a créé l'humain, l'humain a créé l'IA. L'humain, comme l'IA, sont accusés d'avoir des comportements néfastes. Mais Dieu n'est jamais rendu responsable des agissements des Hommes (qui, selon les trois religions monothéistes "principales", font appel à leur libre-arbitre, libérant donc Dieu de sa responsabilité). Ainsi, l'Homme ne veut pas être responsable de ce que fait sa création, et donc accuse l'IA.

C'est plus facile que de changer de comportement.

Économiquement, c'est plus clair : la fabrication de fake-content rapporte. L’argent n’est pas une « réalité » ; c’est un mythe collectif sur lequel on a bâti des incitations. Les plateformes valorisent le temps passé, les partages, les réactions ; elles rémunèrent l’indignation, pas la vérification. La falsification, au fond, est moins dans le pixel truqué que dans la métrique qui l’amplifie.

Reste la crédulité. Pourquoi croire ce qu’on voit — et plus encore ce qu’on voit sur Internet ? On répète depuis des années de ne pas croire ce que les autres disent ou montrent sur Internet, et pourtant, chaque nouvelle technologie nous fait tomber des nues. Ce n’est pas nouveau, c’est juste plus rapide, plus convaincant, plus bruyant.

Blâmer l’outil, oublier les usages

Ce n’est pas parce que l’IA permet de fabriquer un deepfake qu’on doit le faire. On le fait parce que ça paye — en argent, en attention, en réputation. Tant que ce système de rémunération dominera, les « bonnes pratiques » resteront minoritaires.

Pour mémoire, elles existent pourtant :

- croiser l’information entre plusieurs sources

- éviter la bulle cognitive

- indiquer quand un contenu est « généré par IA » (c'est, d'ailleurs, la loi depuis 2023, voir plus bas sur la régulation des créateurs de contenu)

- exercer son esprit critique

- traiter l’IA comme un outil exploratoire.

Ces recommandations n’échouent pas faute de pertinence, mais par dissonance avec l’économie réelle des plateformes (popularité, métriques, commentaires, clics, visionnages, partages) et la paresse intellectuelle. Les incitations gagnent toujours contre la morale abstraite.

Les « solutions »

Réguler les plateformes ? Il faudrait détecter automatiquement les faux, alors que les outils de génération progressent plus vite que les détecteurs, sans parler du volume à analyser (quelque chose comme 5 exabits par jour rien que pour YouTube...). Utiliser l'IA pour détecter les productions IA alors qu'on accuse déjà l'IA de trop consommer de ressources ? L'art et la manière de scier la branche sur laquelle on est assis...

Comme je le disais déjà dans L'humain, cette espèce primitive en 2021 :

[...] empêcher pro-activement la diffusion de certains types de contenus, ou leur demander (ndlr: aux plateformes) de mettre hors-ligne des contenus sous protection intellectuelle, c’est demander une solution technique à des problèmes sociaux

On peut remplacer ici "sous protection intellectuelle" par "générés par IA", cela reste vrai.

Réguler les créateurs ? C'est déjà le cas (loi n°2023-451 du 9 juin 2023, et l'AI Act). Oui mais, si johndoe1984 diffuse un deep-fake à ses 4 followers, mais que janedoe2001 le relaye à ses 10000 followers, on accuse qui ? Et qui sera le plaignant, s'il n'y a pas de visage humain dans le contenu incriminé ? Peut-on vraiment s'insurger, en allant jusqu'à porter plainte, qu'un contenu random trouvé sur les réseaux sociaux ne soit pas représentatif de la réalité ?

En outre, créer des ghettos de contenus (humains d’un côté, IA de l’autre) produirait vite l’effet inverse : une hiérarchie artificielle, donc contournée.

Restreindre la redistribution ? L’idée, défendue par certains (dont moi en 2022), serait d’éviter ou de pénaliser le blanchiment de données numériques. Sur le papier, ça rassure ; en pratique, c’est infaisable à l’échelle du web public : la traçabilité fine des sources est rarement conservée (notamment pour des raisons techniques, pas juste pour emmerder les producteurs de contenu ou par volonté malveillante), encore moins transmise.

On en revient toujours à la même tension : une information n’existe socialement que si elle circule. Sans partage, pas de connaissance ; et le partage devrait rester gratuit, au moins dans son principe. Le droit d’auteur protège déjà, par défaut, les œuvres en France. Mais droit d'auteur ou pas, qui le revendique vraiment, sinon ceux qui ont déjà des reins solides ?

Encore un mot sur le blocage

En plus de ce que j'ai déjà évoqué dans mon article traitant de la question du blocage des "bots IA", je rajoute aujourd'hui que ce blocage aussi fait partie des mythes construits pour fédérer. N'importe quel technicien, n'importe quel geek de la "vieille" génération, sait à quel point les "solutions" proposées sont ineptes. Mais ces articles continuent de générer des clics, et d'avoir des partisans farouches.

- Vous n'avez aucune preuve que les connexions à vos serveurs ont un lien quelconque avec l'Intelligence Artificielle. Vous en avez ? Montrez-les ! Ne vous contentez pas d'accuser.

- Un User-Agent n'a jamais été une source fiable d'information sur le client. Oui, un bot "légitime" peut se faire passer pour autre chose, comme un bot "illégitime" peut se faire passer pour un bot légitime.

- Les bots légitimes ne spamment pas les serveurs avec des milliers de connexions à la seconde, respectent le

robots.txt, et certains vont même jusqu'à vous expliquer eux-mêmes comment les bloquer (y compris avec des techniques un peu plus avancées que ce que les soi-disant experts vous conseillent) : - Le blocage par adresse IP n'est pas fiable, surtout pour bloquer les bots (IA ou non) illégitimes...

- N'importe quel script-kiddy des années 90-2000 est capable de créer un bot de scraping en quelques lignes de python et le déployer sur des milliers de serveurs AWS pour quelques euros, sans jamais utiliser l'IA

- Vous supposez la finalité du scraping dont vous êtes victime : rien ne vous permet de penser que c'est pour "alimenter l'IA"

- On se plaignait déjà du ratissage du web par Google début des années 2000 (et l'impact des Googlebots sur les serveurs web), ce n'est pas pour autant qu'ils ont arrêté

Pour toutes ces raisons, le blocage des "bots d'IA" est une théâtralisation modernisée, donnant l'illusion que l'on contrôle ce qui rentre et ce qui sort de nos serveurs. Grosse news pour vous : ça fait au moins depuis le télégraphe Chappe qu'on essaye de trouver des solutions, et on n'en trouve aucune d'élégante. Pourquoi ? Parce que l'on cherche une solution technique à un problème social : la disparition du bon sens...

Conclusion

L’IA ne « fabrique » pas la réalité, ni ne la déforme, en tout cas pas sans une intention humaine. L'IA fabrique des représentations qui s’insèrent dans un système d’incitations déjà connu : capter l’attention, convertir l’attention en monnaie, alimenter le cycle.

Je ne crois pas aux croisades contre les robots. J'essaye encore de croire aux humains qui acceptent la responsabilité de ce qu’ils publient, de ce qu’ils relaient et de ce en quoi ils croient. C’est moins spectaculaire, c’est plus exigeant. Et c’est, pour l’instant, la seule chose qui peut fonctionner.